Ollama 는 Llama2, Mistral, Gemma 등 대규모언어모델 (LLM)을 개인용 컴퓨터에 설치하고 쉽게 실행할 수 있게 해주는 오픈소스다. 공식 사이트는 다음과 같다.

Ollama를 이용하여 명령창에서 언어모델과 대화할 수도 있지만,

chatGPT 처럼 웹브라우저에서 주고받는 대화가 더 익숙하다.

Open WebUI (구 Ollama WebUI)는 Ollama를 위한 chatGPT 스타일의 웹 인터페이스로서 오픈소스 중에서 가장 인기가 많다고 한다. 윈도나 Mac 노트북에 Open WebUI 를 설치하는 방법은 아래 사이트나 여러 블로그 또는 유튜브에 자세히 나와 있으니 참고하기 바란다.

GitHub - open-webui/open-webui: User-friendly WebUI for LLMs (Formerly Ollama WebUI)

User-friendly WebUI for LLMs (Formerly Ollama WebUI) - open-webui/open-webui

github.com

여기서는 도커(Docker)를 이용하여 설치하는 방법을 소개한다. MacBook Pro M1과 윈도 데스크탑에 다음과 같은 순서로 설치해 봤는데 잘 작동한다.

1. Docker를 설치한다. (https://www.docker.com/))

2. Ollama WebUI 파일을 다운로드할 적당한 폴더를 만들고 이동한다.

3. git clone https://github.com/ollama-webui/ollama-webui.git

4. cd ollama-webui

5. docker compose up -d --build

6. (Docker를 실행시키고) 브라우저 주소창에

http://localhost:3000/

를 입력한다.

그러면 chatGPT와 비슷한 인터페이스를 가진 화면을 볼 수 있다.

7. 이제 언어모델을 설치해야 한다.

https://ollama.com/ 에서 Models 를 보면 다양한 언어모델을 볼 수 있다. 이 중에서 마음이 드는 모델을 몇개 고른다. 모델 설명을 잘 읽어보고 컴퓨터 사양에 맞는 것을 골라야 한다. 인기 있는 모델로는 mistral, llama2, codellama, llava 등이 있다. 최근에 나온 모델로 gemma가 있다.

Open Web-UI 에서 Settings --> Menu 에서 Pull a model from Ollama.com 의 입력창에 사용하고 싶은 언어모델 이름을 써 넣고 다운 받는다.

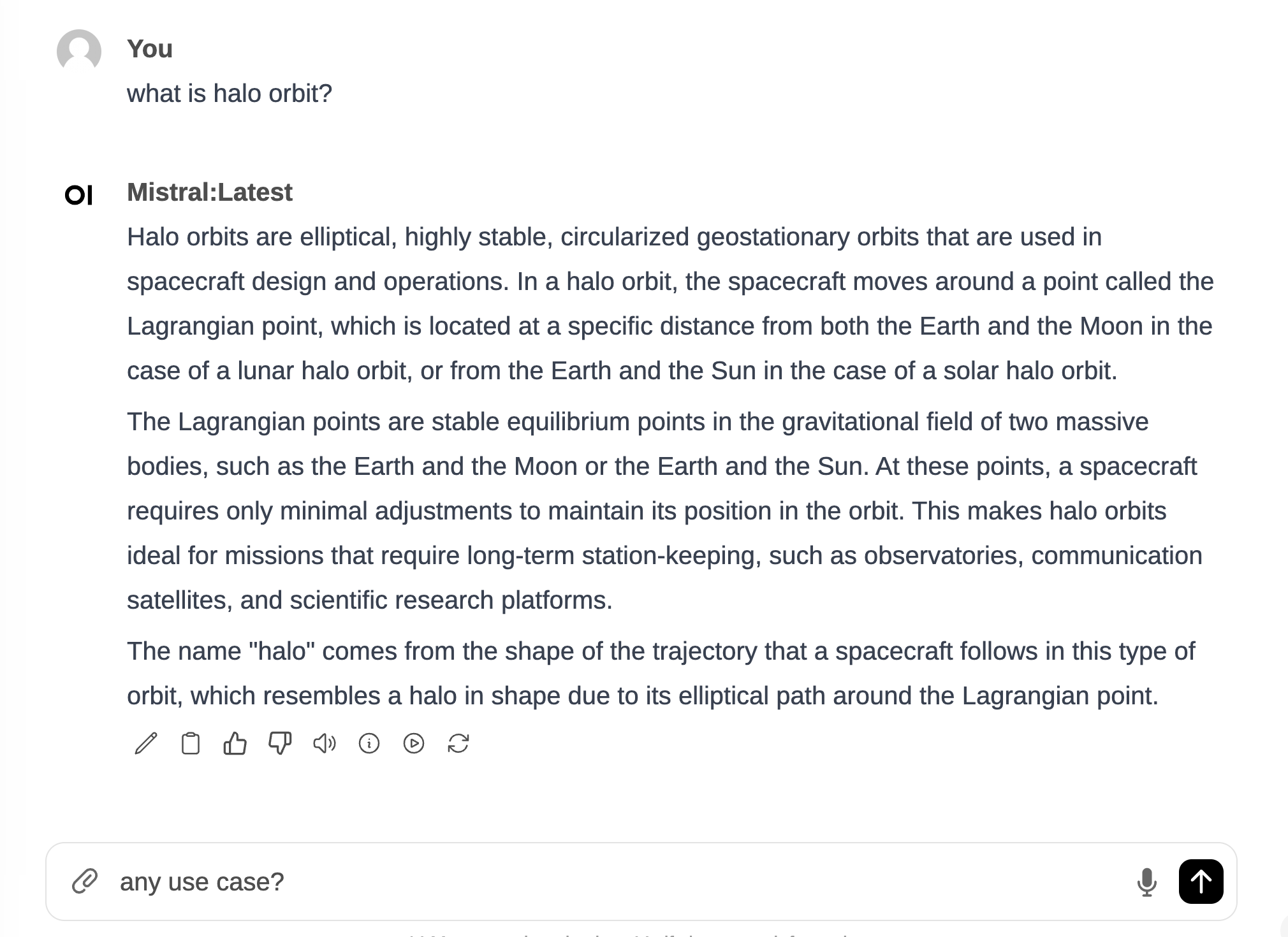

8. 이제 언어모델을 선택하고 사용하면 된다. Mistral 이 빠르고 성능도 좋은 것 같다.

hi mistral 이라고 인사했을 뿐인데 장황하게 대답한 이유는 Settings --> General --> System Prompt 에 내 소개와 언어모델의 역할을 써 넣었기 때문이다.

'AI 에이전트 > AI Tools' 카테고리의 다른 글

| [LLM] Ollama 모델 저장 위치 변경하기 (0) | 2025.08.05 |

|---|---|

| [LLM] Whisper 설치 (0) | 2025.05.11 |

| [LLM] Ollama 모델에서 OpenAI Chat API 사용하기 (0) | 2025.02.15 |

댓글